ZIP 파일 포맷은 일반적으로 자료를 압축하여 보관하는 표준 포맷입니다. 대용량의 데이터를 압축하는 것은 데이터 저장 공간을 적게 사용하고, 데이터 전송에 있어서도 성능 향상을 기대할 수 있으며, 하나의 압축된 파일로 관리할 수 있어 편리합니다.

Python의 zipfile 모듈은 ZIP 파일을 생성하고, 읽기, 쓰기, 추가하기, 압축 파일 해제하기, 압축 파일 리스트와 정보 보기 등을 할 수 있는 클래스를 제공합니다.

이번 포스팅에서는 Python의 zipfile 모듈을 사용해서 (Python 3.x 버전 기준)

(1) 압축 ZIP 파일 쓰기 (write)

(2) 압축 ZIP 파일 읽기 (read)

(3) 압축 ZIP 파일 이름(filename), 자료 리스트(namelist()), 파일 정보(getinfo) 보기

(4) 압축 ZIP 파일 해제하기 (extract)

(5) 웹에서 압축 ZIP 파일 다운로드하여 압축 해제하기 (download and extract)

[ Python zipfile 모듈로 압축 파일 쓰기, 읽기, 해제하기 ]

먼저, Python으로 (a) 압축 ZIP 파일을 다루는 zipfile 모듈과, (b) 경로(directory, path) 및 폴더/파일을 관리를 할 수 있게 해주는 os 모듈을 importing 하겠습니다.

(cf. Python의 os 모듈을 사용해서 경로 및 폴더/파일 관리하는 방법은 https://rfriend.tistory.com/429 포스팅을 참고하세요.)

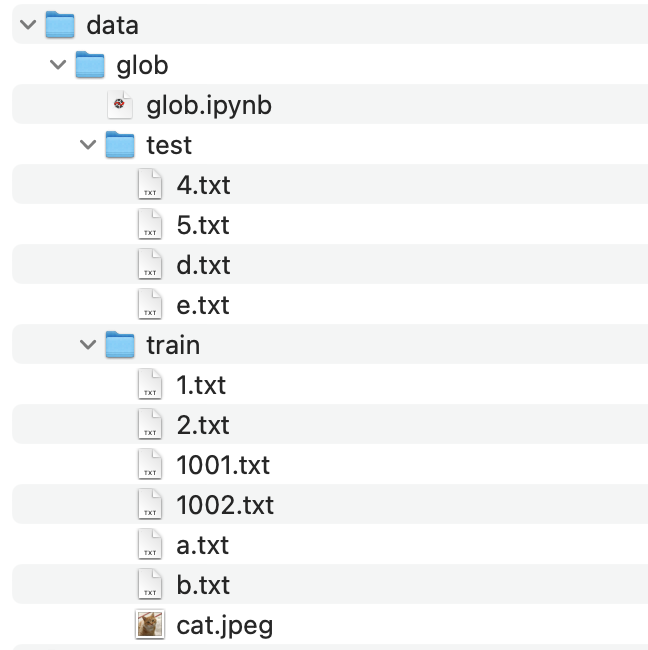

다음으로, os 모듈의 chdir() 함수를 사용해서 "Downloads" 폴더로 작업 경로를 변경하겠습니다.

os.getcwd() 로 현재 작업 경로를 확인해보니 "Downloads" 폴더로 작업 경로가 잘 변경되었네요.

os.listdir() 은 현재 작업 경로에 들어있는 파일 리스트를 반환합니다. ['sample_1.txt', 'sample_2.txt', 'sample_3.txt'] 의 3개 텍스트 파일이 예제로 들어있습니다.

import zipfile

import os

## change working directory

base_dir = '/Users/ihongdon/Downloads'

os.chdir(base_dir)

## check the current working directory

os.getcwd() [Out] '/Users/ihongdon/Downloads'

## show the lists of files in the current working directory

os.listdir()

['sample_2.txt', 'sample_3.txt', 'sample_1.txt']

|

(1-1) mode='w' : 새로운 압축 파일 쓰기 (단, 기존 압축 파일 있으면 덮어쓰기)

zipfile.ZipFile(file, mode='r') 에서 mode 에는 'w', 'x', 'a', 'r'의 4개 모드가 있고, 기본 설정값은 'r' (읽기) 입니다. 이들 4개 모드별 기능은 아래와 같습니다.

[ zipfile.ZipFile(file, mode) 에서 mode='w'/'x'/'a'/'r' 별 기능 ]

- mode='w': 새로운 ZIP 압축 파일을 쓰기 (단, 기존 압축 파일이 있으면 덮어쓰기)

(to truncate and write a new file)

- mode='x': 새로운 ZIP 압축 파일을 쓰기 (단, 기존 압축 파일이 있으면 FileExistsError 발생)

(to exclusively create and write a new file)

- mode='a': 기존 ZIP 압축 파일에 자료 추가하기 (to append additional files to an existing ZIP file)

- mode='r': 기존 ZIP 압축 파일의 자료 읽기 (to read an existing file). 기본 설정 값

myzip_w = zipfile.ZipFile('sample.zip', 'w') 로 'myzip_w'라는 이름의 ZipFile 객체를 새로 만들어 주고, myzip_w.write('sample_1.txt') 함수로 'sample.zip'의 ZIP 파일에 'sample_1.txt' 텍스트 파일을 압축해서 써줍니다.

ZIP 파일을 열고나서 작업 (쓰기, 추가하기, 읽기 등)이 다 끝났으면 시스템이나 프로그램을 종료하기 전에 ZipFile.close() 메소드를 써서 작업 중인 ZIP 파일을 닫아주어야 합니다. 만약 close() 를 하지 않은 상태에서 프로그램을 종료하면 ZIP 파일에 정상적으로 자료가 기록이 되지 않을 것입니다.

ZipFile.is_zipfile(file) 메소드는 ZIP 파일이 존재하면 TRUE를 반환하고, 존재하지 않으면 FALSE를 반환합니다.

## (1) mode='w': to truncate and write a new file

myzip_w = zipfile.ZipFile('sample.zip', 'w')

myzip_w.write('sample_1.txt')

## You must call close() before exiting your program,

## or essential records will not be written.

myzip_w.close()

## ZipFile.is_zipfile(): Return True if a valid ZIP file exists.

zipfile.is_zipfile('sample.zip')

[Out] True

|

ZipFile 객체는 맥락 관리자(context manager) 이므로 'with 문 (with statement)' 을 지원합니다. 따라서 위의 (1-1) 예제 코드를 아래처럼 with 문을 사용해서 ZIP 파일 쓰기를 할 수도 있습니다.

with zipfile.ZipFile('sample.zip', 'w') as myzip:

myzip.write('sample_1.txt')

myzip.close()

|

(1-2) mode='x' : 새로운 압축 파일 쓰기 (단, 기존 파일 있으면 FileExistsError 발생)

위의 mode='w'와는 달리, mode='x'는 새로운 압축 파일을 생성할 때 만약 같은 이름의 ZIP 파일이 존재한다면 'FileExistsError' 가 발생한다는 점이 다릅니다. (to exclusively create and write a new file.)

위의 (1-1)번 예에서 'sample.zip' 이름의 ZIP 파일을 이미 만들었습니다. 여기에 zipfile.ZipFile('sample.zip', mode='x') 로 해서 'sample.zip' 파일 이름으로 ZIP 압축 파일을 만들려고 하면 아래처럼 'FileExistsError: [Errno 17] File exists: 'sample.zip' 의 에러가 발생합니다.

## (2) mode='x': to exclusively create and write a new file.

## if file refers to an existing file, a 'FileExistsError' will be raised.

myzip_x = zipfile.ZipFile('sample.zip', 'x')

[Out]

---------------------------------------------------------------------------

FileExistsError Traceback (most recent call last)

<ipython-input-7-bd84b411165c> in <module>

1 ## (2) mode='x': to exclusively create and write a new file.

2 ## if file refers to an existing file, a 'FileExistsError' will be raised.

----> 3 myzip_x = zipfile.ZipFile('sample.zip', 'x')

~/opt/anaconda3/lib/python3.8/zipfile.py in __init__(self, file, mode, compression, allowZip64, compresslevel, strict_timestamps)

1249 while True:

1250 try:

-> 1251 self.fp = io.open(file, filemode)

1252 except OSError:

1253 if filemode in modeDict:

FileExistsError: [Errno 17] File exists: 'sample.zip' |

위의 'FileExistsError'가 발생했다면, 아래처럼 ZIP 파일 이름을 기존에는 없는 파일 이름으로 바꾸어서 zipfile.ZipFile(new_file_name, mode='x') 로 해서 압축 파일을 생성할 수 있습니다.

(mode='w' 로 하면 기존 파일을 덮어쓰기 하므로 주의가 필요합니다.)

ZipFile.namelist() 는 ZipFile 객체에 압축되어 있는 자료(archives)의 이름 리스트를 출력해줍니다.

myzip_x = zipfile.ZipFile('sample2.zip', 'x')

myzip_x.write('sample_2.txt')

myzip_x.close()

myzip_x.namelist()

[Out] ['sample_2.txt']

|

(1-3) mode='a' : 기존 ZIP 압축 파일에 자료 추가 (to append, add up)

만약 기존에 존재하는 ZIP 파일에 새로운 자료를 추가(append)하고 싶다면 mode='a' 로 설정해주면 됩니다.

아래 예제에서는 위의 (1-1)에서 'sample_1.txt'의 텍스트 파일을 'sample.zip' 이름으로 압축해서 이미 만들어두었던 ZIP 파일에 더하여, 'sample_2.txt', 'sample_3.txt' 의 텍스트 파일까지 추가하여 'sample.zip' 이름의 ZIP 파일에 압축해보겠습니다.

## (3) mode='a': to append to an existing file.

myzip_a = zipfile.ZipFile('sample.zip', 'a')

myzip_a.write('sample_2.txt')

myzip_a.write('sample_3.txt')

myzip_a.close()

myzip_a.namelist()

[Out] ['sample_1.txt', 'sample_2.txt', 'sample_3.txt']

|

(1-4) 여러개의 자료를 하나의 압축 ZIP 파일에 쓰기 (for loop, ZipFile(), write())

하나의 ZIP 압축 파일에 여러개의 자료를 압축해서 쓰고 싶을 때는 for loop 반복문을 같이 사용해주면 됩니다. (mode 는 필요와 상황에 맞게 'w', 'x', 'a' 중에서 선택)

아래 예제는 'myzip_all' 이름의 ZipFile 객체로 'sample_all.zip' 의 ZIP 파일에 ['sample_1.txt', 'sample_2.txt', 'sample_3.txt'] 의 3개 텍스트 파일들을 for loop 반복문을 사용해서 하나씩 차례대로 호출해서 myzip_all.write(f) 로 'sample_all.zip' 파일에 써주었습니다.

## (4) writing files to a zip file: with statement & for loop

file_list = ['sample_1.txt', 'sample_2.txt', 'sample_3.txt']

with zipfile.ZipFile('sample_all.zip', 'w') as myzip_all:

for f in file_list:

myzip_all.write(f)

print(f, 'is written to myzip_all.zip')

myzip_all.close()

[Out]

sample_1.txt is written to myzip_all.zip

sample_2.txt is written to myzip_all.zip

sample_3.txt is written to myzip_all.zip

myzip_all.namelist() [Out] ['sample_1.txt', 'sample_2.txt', 'sample_3.txt']

|

(1-5) zipfile.ZipFile(file, mode='r',

compression=ZIP_STORED, allowZip64=True, compresslevel=None)

매개변수

|

설명

|

compression |

compression은 자료를 압축 파일에 쓰기 위한 ZIP 압축 메소드이며, 기본 설정값은 ZIP_STORED 입니다.

Python 버전 3.1 부터 아래의 파일과 같은 객체를 지원합니다.

- zipfile.ZIP_STORED (* default)

- zipfile.ZIP_DEFLATED

- zipfile.ZIP_BZIP2

Python 버전 3.3 부터는 ZIP_LZMA 객체를 지원합니다.

|

allowZip64 |

allowZip64=True (기본 설정) 이면 ZIP 파일 크기가 4GB를 넘을 경우 ZIP64 extensions 를 사용해서 ZIP 파일을 생성합니다.

만약 allowZip64=False 설정인데 ZIP 파일 크기가 4GB를 넘을 경우에는 exception error 가 발생합니다.

|

compresslevel |

compresslevel 매개변수는 자료를 압축할 수준을 지정할 때 사용합니다.

(compression 이 ZIP_STORED, ZIP_LZMA 일 경우에는 효과가 없으며, ZIP_DEPLATED, ZIP_BZIP2 에만 설정 가능합니다.) - compression=ZIP_DEFLATED 일 경우 compresslevel=0~9 까지 설정 가능

- compression=ZIP_BZIP2 일 경우 compresslevel=1~9 까지 설정 가능

|

ZIP 압축 파일에 들어있는 자료를 읽으려면 zipfile.ZipFile(file, mode='r') 로 해서 ZipFile 객체를 '읽기 모드'로 생성한 후, ZipFile.read() 메소드로 ZIP 파일 내 압축되어 있는 자료를 읽을 수 있습니다.

아래 예제는 위의 (1-1)에서 만들었던 'sample.zip'의 ZIP 파일 안에 압축되어 있는 'sample_1.txt' 텍스트 자료를 읽어본 것입니다. 압축을 해제하지 않고도 ZIP 압축 파일 내의 특정 자료를 선택해서 그 자료만 읽을 수 있어서 편리합니다.

## sample.zip

myzip_w.namelist()

[Out] ['sample_1.txt']

## mode='r': to read an existing file

myzip_r = zipfile.ZipFile('sample.zip', 'r')

print(myzip_r.read('sample_1.txt'))

[Out] b'x1,x2,x3\n1,2,3\n4,5,6\n7,8,9\n'

# ## or equivalently above

# with myzip_r.open('sample_1.txt') as s1:

# print(s1.read())

|

위의 압축 파일 내 자료를 읽은 결과가 눈에 잘 안들어 올 수도 있는데요, 아래에는 참고로 pandas 의 read_csv() 메소드를 사용해서 'sample_1.txt' 파일을 출력해본 것입니다.

import pandas as pd

sample_1_df = pd.read_csv('sample_1.txt')

print(sample_1_df)

[Out]

x1 x2 x3

0 1 2 3

1 4 5 6

2 7 8 9

|

(3) 압축 ZIP 파일 이름(filename), 자료 리스트(namelist()), 파일 정보(getinfo) 보기 |

(3-1) ZipFile.is_zipfile(file) : Zip 파일이 존재하면 True, 존재하지 않으면 False

file_list = ['sample_1.txt', 'sample_2.txt', 'sample_3.txt'] with zipfile.ZipFile('sample_all.zip', 'w') as myzip_all:

for f in file_list:

myzip_all.write(f)

myzip_all.close()

## ZipFile.is_zipfile(): Return True if a valid ZIP file exists.

zipfile.is_zipfile('sample_all.zip')

[Out] True |

(3-2) ZipFile.filename : ZIP 압축 파일 이름 출력

## ZipFile.filename: Name of the ZIP file

myzip_all.filename

[Out] 'sample_all.zip'

|

(3-3) ZipFile.namelist() : ZIP 압축 파일 내 자료 이름 리스트 출력

## file name lists of sample_all.zip

myzip_all.namelist()

[Out] ['sample_1.txt', 'sample_2.txt', 'sample_3.txt']

|

(3-4) ZipFile.getinfo(member) : ZIP 파일 내 자료(member)의 정보 출력

파일 이름 (file name), 파일 모드 (file mode), 파일 크기 (file size)

## ZipFile.getinfo(): Zip information about the archive member name.

myzip_all.getinfo('sample_1.txt') [Out] <ZipInfo filename='sample_1.txt' filemode='-rw-r--r--' file_size=27>

|

(4) 압축 ZIP 파일 해제하기 (extract) |

(4-1) ZipFile.extract(file, path) : ZIP 파일 내 1개의 자료만 압축 해제하기

이때 압축을 해제한 자료를 저장할 경로(path)를 별도로 지정해 줄 수 있습니다. (path 를 지정하지 않으면 현재 작업경로에 압축 해제함)

## (4-1) ZipFile.extract()

## : extracting a member from the archive to the current working directory.

extract_path = '/Users/ihongdon/Downloads/sample_3'

zipfile.ZipFile('sample_all.zip').extract('sample_3.txt', path=extract_path)

[Out] '/Users/ihongdon/Downloads/sample_3/sample_3.txt' |

위의 (4-1)에서는 압축 해제한 1개 파일을 저장할 경로(path)를 지정해주었는데요, 해당 경로에 os.listdir(extract_path) 로 확인해 보니 원하는 'sample_3.txt' 텍스트 자료가 잘 압축 해제되어 저장되어 있네요.

os.listdir(extract_path) [Out] ['sample_3.txt'] |

(4-2) ZipFile.extractall() : ZIP 파일 내 모든 자료를 압축 해제

## (4-2) ZipFile.extractall()

## : extracting all members from the archive to the current working directory.

extractall_path = '/Users/ihongdon/Downloads/sample_all'

zipfile.ZipFile('sample_all.zip').extractall(extractall_path)

os.listdir(extractall_path) [Out] ['sample_2.txt', 'sample_3.txt', 'sample_1.txt']

|

(5) 웹에서 ZIP 파일 다운로드하여 압축 해제하기 (download and extract ZIP file) |

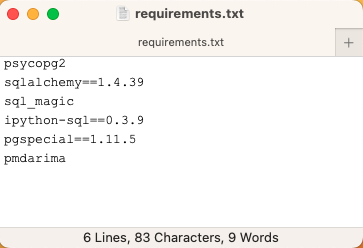

아래 예제는 웹사이트에서 영화 추천에 사용되는 영화 평가 점수(movie ratings)를 모아놓은 데이터셋('movielens.csv', etc.)을 ZIP 포맷으로 압축해 놓은 'ml-latest-small.zip' 파일을 Keras의 메소드를 사용해 다운로드 한 다음에, zipfile 모듈의 ZipFile.extractall() 메소드로 전체 자료를 압축 해제한 것입니다.

## Download the movielens data from website url

import tensorflow.keras as keras

from zipfile import ZipFile

from pathlib import Path import os

movielens_data_file_url = (

"http://files.grouplens.org/datasets/movielens/ml-latest-small.zip"

)

movielens_zipped_file = keras.utils.get_file(

"ml-latest-small.zip", movielens_data_file_url, extract=False

)

keras_datasets_path = Path(movielens_zipped_file).parents[0]

movielens_dir = keras_datasets_path / "ml-latest-small"

## Only extract the data the first time the script is run.

if not movielens_dir.exists():

with ZipFile(movielens_zipped_file, "r") as zip:

zip.extractall(path=keras_datasets_path) # extract all members in a ZIP file

|

사용자 별 영화 평가점수('ratings.csv')와 영화 정보('movies.csv') 데이터셋을 사용해서 영화 추천 (movie recommentation) 에 사용할 수 있습니다.

print('datasets path:', keras_datasets_path)

[Out] datasets path: /Users/ihongdon/.keras/datasets

print(os.listdir(keras_datasets_path)) [Out] ['cowper.txt', 'reuters_word_index.json', 'imdb_word_index.json', 'flower_photos.tar.gz', 'cifar-10-batches-py', 'mnist.npz', 'ml-latest-small.zip', 'ml-latest-small', 'fashion-mnist', 'butler.txt', 'imdb.npz', 'cifar-10-batches-py.tar.gz', 'boston_housing.npz', 'creditcard.csv', 'creditcard.zip', 'derby.txt', 'train.csv', 'flower_photos', 'reuters.npz', 'fsns.tfrec']

os.listdir(movielens_dir) [Out] ['links.csv', 'tags.csv', 'ratings.csv', 'README.txt', 'movies.csv']

|

[Reference]

* zipfile -Work with ZIP archives: https://docs.python.org/3/library/zipfile.html

이번 포스팅이 많은 도움이 되었기를 바랍니다.

행복한 데이터 과학자 되세요! :-)